GPUが脚光を浴びる

ChatGPTやStable Diffusionに代表される生成AIが大きな話題を集めている。ChatGPTが公開されたのは2022年11月、Stable Duffsionが公開されたのは2022年8月だが、そこからわずか1年半で生成AIは大きく進化し、生成AIを活用したさまざまなサービスがリリースされるようになった。ChatGPTを開発したOpenAIやStable Diffusionを開発したStability AIのようなAIベンチャーだけでなく、GoogleやMicrosoftといった大手IT企業も生成AIに注力している。生成AIは、従来のAIの延長線上にあるものだが、従来のAIは画像や文章を与えることで、画像に映っているものを判別したり文章の要約や翻訳を行うものである。それに対し、生成AIは指示(プロンプト)を与えることで、その指示に従った画像や文章を新たに生成することが特徴だ。Stable Diffuisonのように画像を生成する生成AIを画像生成AI、ChatGPTのように文章を生成する生成AIを文章生成AIと呼ぶが、どちらもモデルの学習には膨大な演算が必要になる。特に、ChatGPTの基盤であるGPTシリーズや最新のGPT-4を上回る性能を発揮するといわれているClaude 3といった、LLM(Large Language Models:大規模言語モデル)は、その名の通り大規模なモデルであり、基本的にはモデルが大きくなるほど性能が向上するため、学習には非常に大きな演算リソースが必要になる。

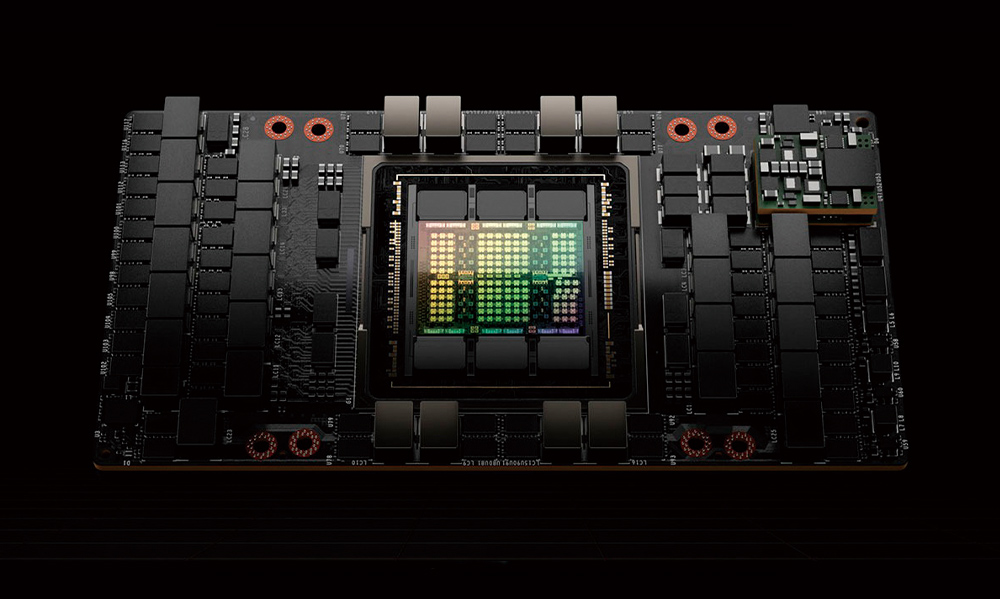

こうした生成AIの学習を支えているのが、GPUである。GPUはGraphics Processing Unitの略であり、もともとグラフィックス描画、特に3次元描画に必要な演算を高速に行うチップとして開発されたものだが、3次元描画では同じ演算を非常にたくさん繰り返すことが多い。同じ演算を高速に行うには、小さな演算コアを多数搭載し、並列処理を行うアーキテクチャーが向いている。最新のハイエンドGPUでは、1つのチップに約1万5,000個~1万8,000個もの演算コアを集積しており、演算コアがせいぜい数十のCPUとは比べものにならない演算性能を誇る。こうした並列処理に特化したGPUのアーキテクチャーは、同じ演算をたくさん繰り返すディープラーニングの学習や推論にもマッチするため、GPUを使ったディープラーニングが脚光を浴びるようになった。2000年代から始まり、現在も続いている第3次AIブームも、GPUがあったからこそ実現したのだ。当初は、グラフィックス用として開発されていた汎用GPUをAIの開発に使っていたが、AI需要が急速に増加したため、世界最大のGPUメーカーであるNVIDIAも、AI処理に特化したAI向けGPUを開発するようになった。

AI向けGPUの特徴

AI向けGPUは、通常のGPUよりも搭載メモリが大きいことが特徴だ。LLMのような大規模なモデルを効率良く学習させるには、多量のメモリが必要になる。一般的なGPUでは、メモリ容量が6GB~16GB程度が主流だが、AI向けGPUでは48GB~80GBが主流だ。例えば、NVIDIAのAI向けGPU「NVIDIA H100」は1万4,592個の演算コアと80GBのメモリを搭載し、8ビット精度なら最大4PFLOPSもの演算性能を発揮する。1つのGPUで、一昔前のスーパーコンピューター並みの性能を実現しているのだ。GPTシリーズやClaude 3などのLLMでは、こうしたAI向けGPUを数千個から数万個も使って学習をさせている。例えば、GPT-4の学習には、2万5,000個のA100(NVIDIA H100の前世代の製品)を使って、約3ヶ月かかったことが明らかにされている。NVIDIA H100は、1つ500万円程度という高価なものだが、こうしたGPUを何個持っているかということが、LLMの開発速度を大きく左右する。実際に、生成AI(LLM)を開発している企業は、GPUをいかに確保するかという争奪戦の状況を呈している。中でも積極的な投資を計画しているのが、マーク・ザッカーバーグが率いるMeta Platformsであり、生成AIやさらにそれを超える汎用人工知能(AGI)の開発のために、2024年末までにH100を35万個購入すると表明した。これまでにMeta Platformsが所有しているH100やその他のGPUも加えると、60万個のH100に相当する処理能力を持つことになるという。

H100は巨大なチップであり、生産量が限られている。NVIDIAは、2023年度にH100をワールドワイドで55万個出荷する見込みだと表明したが、それでも足りず、納期が半年から1年以上も先になっているのが現状だ。NVIDIAは、2024年度には2023年度の3倍以上の数のH100を出荷する計画だが、その目標の達成はそう容易ではない。

また、計画通りに生産できたとしても、数万個~数十万個のGPUを購入するには、巨額の資金が必要だ。前述したMeta Platformsが、35万個のH100を1つ500万円で購入するなら、1兆7,500億円もの資金が必要になる。日本でも独自LLMを開発している企業や研究機関はいくつかあるが、MetaやGoogle、OpenAIなどに比べると、所有している計算リソース(GPU数)は微々たるものだ。最近、演算量やメモリ容量を大きく減らせる1bitLLMと呼ばれる技術が登場したが、こうしたブレイクスルーによって多量のGPUを使わずに、同等の性能が得られるようになる可能性もある。