生成AIをはじめとする最新テクノロジーがオフィスツールへ搭載され始めている。それらのテクノロジーを効率よく活用するために搭載が必要な最新CPUもアナウンスされている。業務を効率化するツールとして、これからのPC選びは何を基準としたらよいのか?その判断に必要な情報をまとめてみた。

Core Ultraが到達した二つのマイルストーン

昨年12月、インテルは「Core i」シリーズに代わるハイエンドブランド「Core Ultra」を正式発表した。開発コードネームMeteor Lakeとしてかねて予告されていた新プロセッサーの登場は、二つの点で大きな一歩だった。

一つは、EUV(極端紫外線)露光技術を採用した最先端プロセスIntel 4として初の量産製品である点だ。

半導体チップはこれまで光(紫外線)を設計図であるマスクに投射し、透過した光をレンズで縮小し露光(転写)することでナノレベルの素子や配線を実現してきた。露光精度を高め、さらなる微細化を図るには、光の波長をより短くすることが有効だ。EUV露光技術を一言でいえば、より短い波長を採用した露光技術ということができるが、その実現は決して容易なことではなかった。なぜならEUV光はレンズを透過しないため、これまでとは異なる製造プロセスを採用する必要があるからだ。詳細な説明は避けたいが、ニコンやキヤノンといった日本を代表する光学機器メーカーもさじを投げた技術といえば、その難易度の高さを理解いただけるはずだ。

EUV露光装置の製品化に唯一成功したのはオランダの半導体製造装置メーカーASMLで、独占状態は今も続いている。EUV露光技術をはじめて商用化したのは、世界最大のファウンドリであるTSMCで2019年のこと。インテルの量産はサムソンに続き3社目になる。今後の半導体微細化においてEUV露光技術は不可欠とみられるだけに、2030年までにファウンドリビジネスで世界2位を目指すインテルにとり大きな一歩になったことは間違いない。

そしてもう一つが、こちらも同社として初となるNPU(ニューラル・プロセシング・ユニット)の搭載である。タイルアーキテクチャが採用されたCore Ultraには、Computeのほか、GPU、IO、SoCの4タイルが搭載され、NPUは無線LAN機能などの周辺機能と共にSoCタイルにまとめられている。

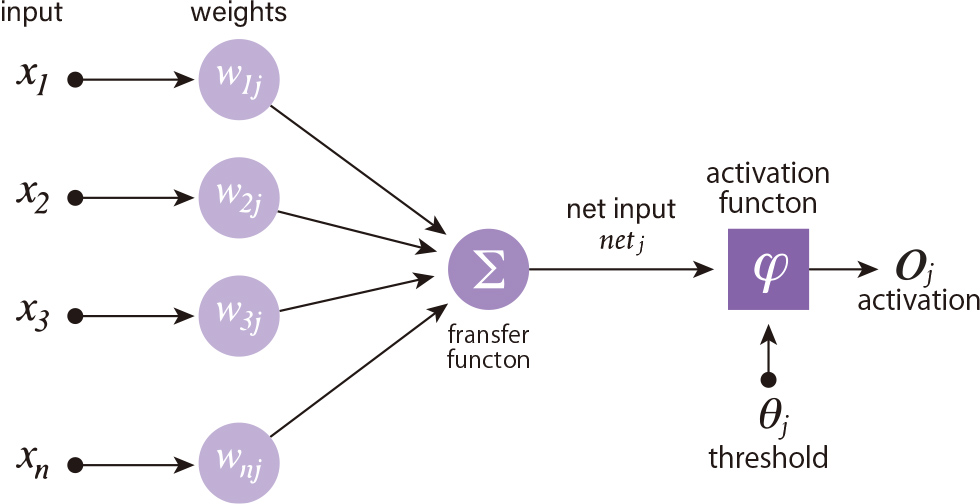

ここでNPUについて簡単に説明しておきたい。近年の生成AIの爆発的な進化において、大量のデータからその背後にあるルールやパターンをコンピューター自身が学ぶ機械学習は切り離せない。生物の学習プロセスは、神経細胞への入力信号の総和がしきい値を超えると次の段階に進む、無数の神経細胞の働きの連鎖を通して行われる。ニューラル・ネットワークと呼ばれる生物の脳の仕組みを数学モデル化し、AI開発に応用したのが機械学習である。

次にこの処理をコンピューターで行うことを考えてみたい。細胞への入力の総量は刺激の強さ×回数というシンプルな行列計算で得られ、64ビットの浮遊点計算などは必要なく、8ビット、16ビットの計算コアを多数用意した方が効率的だ。NPUは生物のニューラル・ネットワークをハードウェアレベルで再現することで、機械学習の一連の処理を高速かつ省電力で行うことを目的としたユニットということができる。

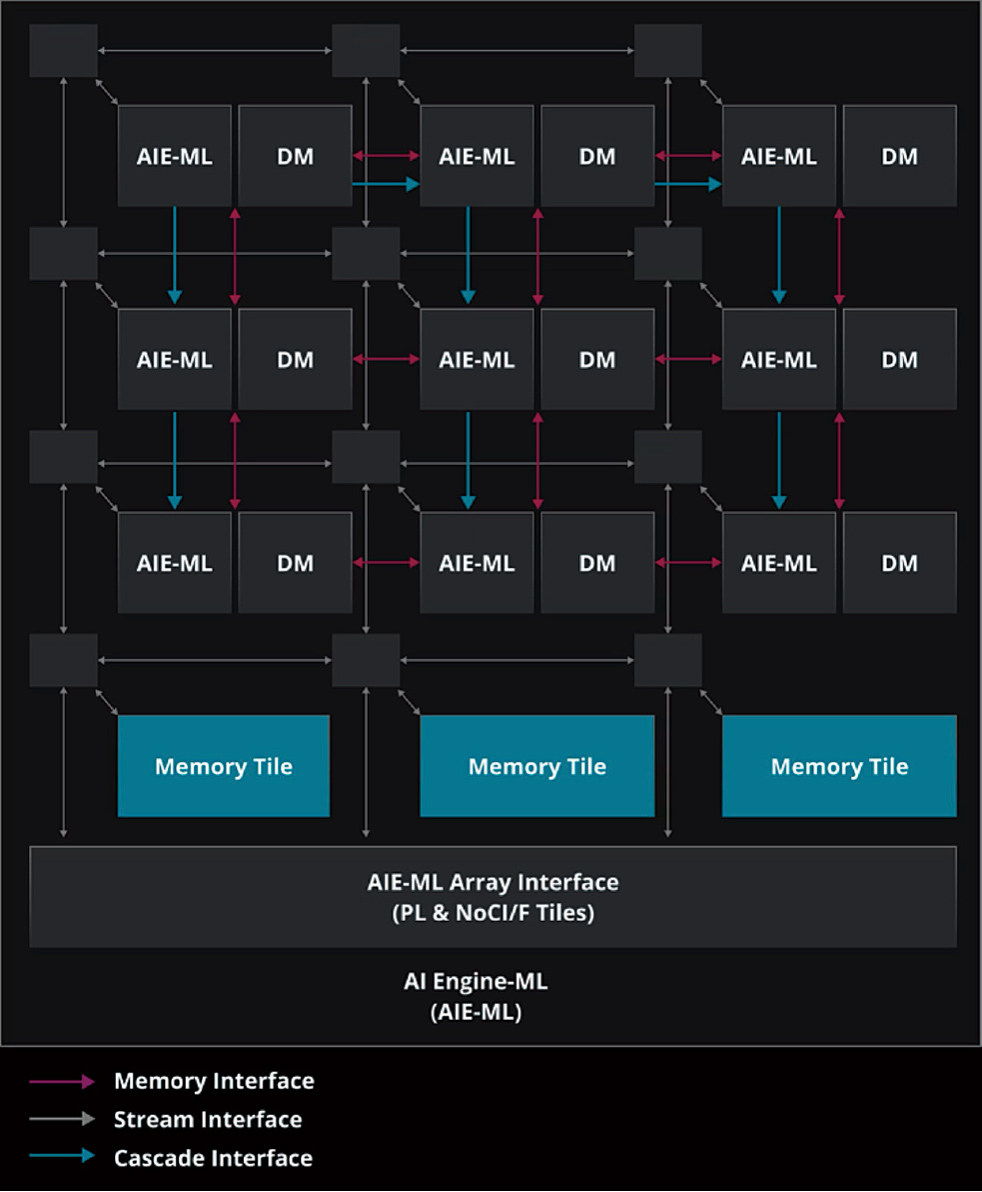

なおNPU搭載プロセッサは、Core Ultraに先行し、Apple、AMD、Qualcommなどの半導体メーカーがすでに製品化している。NPUの意義を正しく理解するため、ここではAMD Ryzen 7040および8040シリーズプロセッサに搭載されたAIエンジン「XDNA AI」を例にもう少し深掘りしてみよう。

AIエンジンプロセッサをタイル状の配列で構成したアーキテクチャを採用したXDNA AIでは、各エンジンそれぞれに、ベクトル型及びスカラー型プロセッサ、ローカルデータとプログラムメモリが含まれる。それによりデータを繰り返しキャッシュから取得する必要がある(つまりエネルギーを消費する)既存のアーキテクチャとは異なり、機械学習をより効率的で低消費電力のコンピューティングで実行することが可能になる。ニューラル・ネットワークが大規模かつ複雑化する中、低電力でより高い演算密度を得たいというニーズに応えるうえで不可欠な技術であることは間違いないだろう。なお、AMDのAIアクセラレータカードは、癌の早期発見をAI画像診断で行うAIメディカルサービスなど多様な領域ですでに採用されているという。

ちなみに、プロセッサーへのGPU(グラフィックス・プロセシング・ユニット)搭載にも同様の事情がある。データから画像を生成するレンダリングには大きなリソースが割かれるが、実際のプロセスは光の三原色であるRGPそれぞれの8ビット処理が大量に行われている。そのニーズに応え、低スペックのコンピューティングリソースを並行稼働するというのがGPUの考え方になる。機能的にもGPUとNPUは近く、インテルはCore UltraのAIアクセラレーション機能は、CPU、GPU、NPUに分散して実装されていると説明している。

AI PC市場を占う上で注目したいMetaとQualcommの関係

インテルは、NPU搭載のCore UltraシリーズをAI PCの中核に位置付けている。ここで、新たな疑問が浮かぶ。それは、なぜデバイスに機械学習の機能が必要なのかという疑問だ。

ChatGPTやMicrosoft Copilot、Adobe Fireflyといった機械学習を前提とした生成AIはどれもユーザーのリクエストに応じてクラウドで処理を実行し、その結果を返すSaaSとして運用されている。Windows 11ではデスプトップ常駐型のCopilot in Windowsが登場したが、これも基本的にはSaaS型だ。

AI PCの可能性を考えるうえで参照したいのが、スマートフォンにおけるAI機能実装の歴史だ。ご存じの方も多いはずだが、デバイスへのAI機能実装はスマホが先行している。AIによるリアルタイムの画像・動画処理がそれだ。こうした中、スマホ用チップセット市場で高いシェアを持つQualcommのSnapdragonシリーズには、早くから「Hexagon NPU」(旧名称Hexagon DSP)と名付けられたNPUが搭載されている。スマホのAI機能の第一の役割が画像・映像の処理にあることは間違いないと思われるが、デバイスのAI基盤を新たな用途に活用しようとする取り組みもスタートしている。

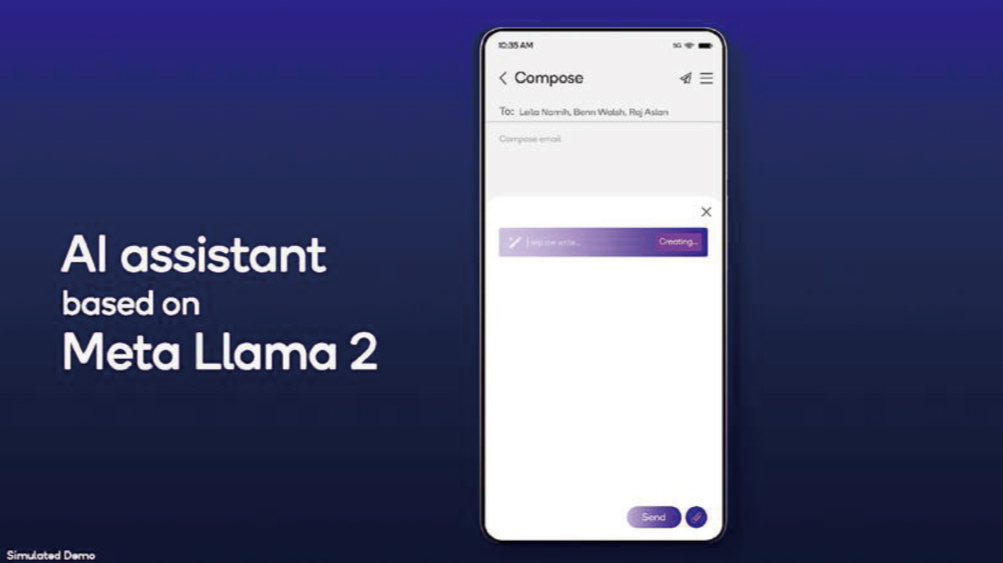

昨年7月、QualcommはMetaと大規模言語モデル(LLM)Llama 2をSnapdragon搭載端末で実行できるようにする提携を結んだことを発表した。Llama 2とは、Metaが独自開発するLLM。自然言語による対話、質問応答システム、文章生成、言語翻訳、議事録など文書の作成などが可能で、基本的な機能はChatGPTと同様と考えていい。大きな違いは、モデルサイズにある。

LLMはデータ量と計算量、パラメータ数が多ければ多いほど学習速度も高速化する。しかしそれによるモデルサイズ増大は、当然ながらコンピューティングリソースの負荷増大に直結する。こうした中、高度な機械学習をより小さなモデルサイズで実行することを目指しているのがMetaのLlama 2である。

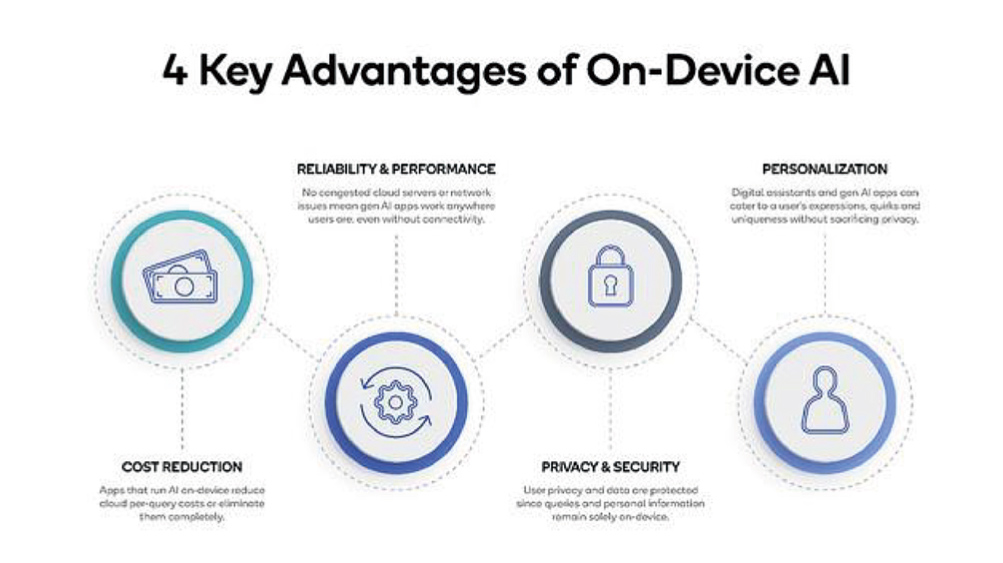

提携発表の際のプレスリリースでQualcommは、デバイス側がAIを実行するメリットとして以下の4点を挙げている。

1. クラウドコスト削減

2. 信頼性とパフォーマンス向上

3. プライバシーとセキュリティの担保

4. パーソナライゼーション

その中で特に注目したいのは、4のパーソナライゼーションである。同社がシナリオとして挙げるのは、例えばこんな用途だ。「サーフィンが趣味のあるユーザーは、スマホで情報を収集し、仲間と連絡を取り合っている。出張先で時間が空いた彼がスマホを手に取ると、まっさきに表示されるのが近隣のサーフスポット情報だった……。」

機械学習をデバイス上で行うことによる、趣味・趣向やライフスタイルに最適化された情報収集の実現は、求める情報になかなかたどり着けないというインターネット検索エンジンの課題解決の選択肢の一つになることは間違いない。

同様のことは、PCのビジネスユーザーにとってもいえる。現在Copilot for Microsoft 365は、テナント内の多様なデータに基づきAIが業務を支援するサービスを提供しているが、「なにを調べたか」「どの相手とどんなコミュニケーションを取っているか」「どのようなドキュメントを作成したか」などの情報がユーザーレベルで把握できれば、その精度はさらに高まることは間違いないはずだ。

すでに動き始めたAI PCを巡る合従連衡

興味深いのはChatGPT同様、MetaのLlama 2にもマイクロソフト社が深く関わる点だ。マイクロソフト社は昨年7月、Azure及びWindowsにおいてLlama 2をサポートすることを発表している。

Windows 11では、Paint、Photo、Snipping Toolなどの画像処理系ツールやセキュリティツールにおいて、すでにAIによる機械学習の利用がスタートしている。その際にLlama 2の特長であるモデルサイズの小ささが大きな役割を果たすことは間違いない。

AI PCは、対応するソフトウェアがあってはじめて魅力的な体験が可能になる。インテルはCore Ultra発表に先立ち2023年10月、2025年までに1億台のPCへのAI導入を目標とする「AI PCアクセラレーション・プログラム」を発表。

すでにAdobe、Zoomをはじめとする100社を上回るソフトウェアベンダーがプログラムに参画し、Core Ultraへの最適化によるオーディオ効果、コンテンツ制作、セキュリティ、ビデオ会議など広範に渡るPC体験の強化を図っている。

AI PCの普及は緒についたばかりだ。気が付くとアプリケーションに実装されたAIが日常業務を支援し、アートや音楽表現の可能性を広げる世界が当たり前のことになっているのかもしれない。